Яким чином досвід у сфері кліматичної політики може стати запобіжником для суспільства від некерованого прогресу штучного інтелекту?

Цю інформацію передає "Kreschatic", посилаючись на The Conversation.

Орієнтування в підземних сферах експериментів та таємна еволюція штучного інтелекту. Недоліки сучасних методів регулювання. Уроки управління кліматом: як залишатися адаптивними. Уникнути повторення помилок попередніх кліматичних ініціатив.

Штучний інтелект набирає стрімких обертів, але темпи його регулювання значно відстають. Незважаючи на зусилля держав та міжнародних організацій, правові механізми не встигають адаптуватися до непередбачуваних форм використання новітніх технологій. Поширення глибоких фейків, маніпулятивного контенту та неконтрольованих експериментів у відкритих спільнотах свідчать про вразливість існуючих підходів.

Світова спільнота вже зіштовхувалася з подібними викликами, коли намагалася знайти рішення для проблем, пов'язаних із кліматичною кризою. Досвід, отриманий у процесі кліматичного регулювання, може слугувати дороговказом для модернізації законодавства, щоб воно відповідало вимогам ери штучного інтелекту.

Політика реагування на зміни клімату формувалася протягом десятиліть через численні експерименти, міжнародні угоди, кризи довіри та спроби залучити всі зацікавлені сторони до спільного пошуку рішень. Цей досвід підтверджує, що для ефективного регулювання складних технологій необхідний міждисциплінарний підхід, стратегічне бачення на тривалий термін та гнучкі механізми впливу. Ігнорування цих аспектів у сфері штучного інтелекту може призвести до наслідків, які не менш серйозні, ніж ті, що пов’язані зі змінами клімату.

Тайні сфери експериментування та прихована еволюція штучного інтелекту.

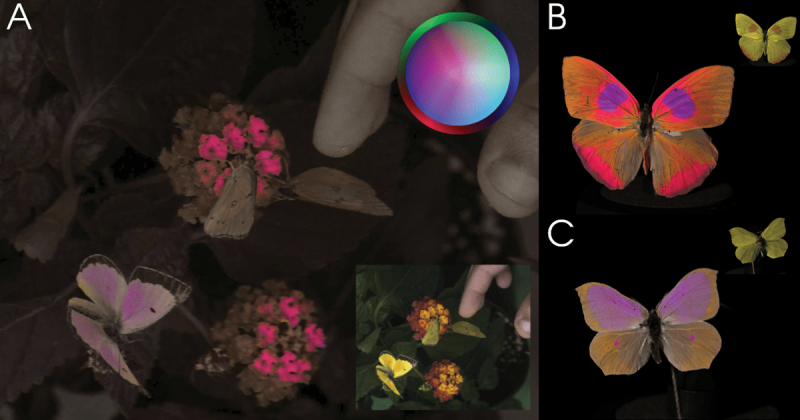

Онлайн-платформи, такі як GitHub, Hugging Face та Reddit, перетворюються на середовища для несанкціонованого або експериментального використання штучного інтелекту. У цих громадах програмісти та ентузіасти змінюють вихідний код моделей, ігноруючи етичні стандарти та регуляторні вимоги. Саме так з'явилися перші глибокі фейки, які згодом проникли на популярні платформи, викликавши низку репутаційних і юридичних криз.

Природа цих "андерсфер" передбачає швидку адаптацію та розповсюдження ризикованих інновацій. У традиційних правових системах просто немає інструментів, які б дозволяли вчасно реагувати на подібні виклики. Це створює ситуацію, коли шкода вже нанесена, а законодавчі реакції відстають на роки. Такий розрив між реальністю й нормами потребує переосмислення засад самого регуляторного мислення.

Недоліки чинного підходу до регулювання

Європейський Союз, Сполучені Штати, Китай та інші країни створили основні принципи для класифікації систем штучного інтелекту відповідно до їх ризикового потенціалу. Проте основна увага зосереджена на передбачуваних сценаріях їх використання. Це призводить до того, що безліч креативних і небезпечних можливостей залишаються ігнорованими. Саме ці варіанти часто представляють найбільшу загрозу для суспільства.

Коли регуляція орієнтована виключно на "офіційне" застосування, вона не здатна охопити повний спектр потенційних наслідків. До прикладу, глибокі фейки початково розглядалися як розважальна технологія. Лише після її застосування в порушеннях прав людини, політичних маніпуляціях та кібершахрайстві, регулятори почали реагувати. Це запізнення коштує занадто дорого в умовах високої швидкості розвитку ШІ.

Уроки кліматичного управління: як діяти гнучко

Кліматичне управління за останні десятиліття напрацювало підхід до боротьби з ризиками, які складно передбачити. У ньому визнається невизначеність, множинність джерел ризику та необхідність міжнаціональної координації. Ці ж принципи мають бути застосовані до сфери штучного інтелекту, щоб уникнути фрагментації регуляцій і втрати контролю над процесами.

Системний погляд на проблему дозволяє врахувати ризики, які виникають унаслідок поєднання ШІ з соціальними мережами, повторного використання коду, або поширення напівправди в медіапросторі. Регулювання має враховувати не лише поточні ризики, а й потенційні сценарії їхнього розгортання в майбутньому. І головне -- залучати до дискусії всі зацікавлені сторони, включно з громадянським суспільством, наукою та бізнесом.

Уникнути повторення помилок кліматичних проектів.

Разом із потенціалом кліматичних практик існують і небезпеки, які не можна копіювати. Політична нестабільність, лобізм та затягування рішень стали перепонами в реалізації кліматичних цілей. Те саме може відбутися зі ШІ, якщо не буде створено незалежних механізмів перевірки, прозорості та контролю з боку громадськості.

Слід враховувати, що проблема має глобальний характер і постійно змінюється. Стандарти безпеки та відповідальності повинні бути узгоджені на міжнародному рівні. Водночас варто визнати, що заборони не зупинять технологічний прогрес, однак існує можливість розумного співіснування з новими технологіями через адаптивне, оперативне та прозоре регулювання.

Нагадуємо, що раніше ми обговорювали питання, чи здатні штучні інтелекти проявляти емпатію.