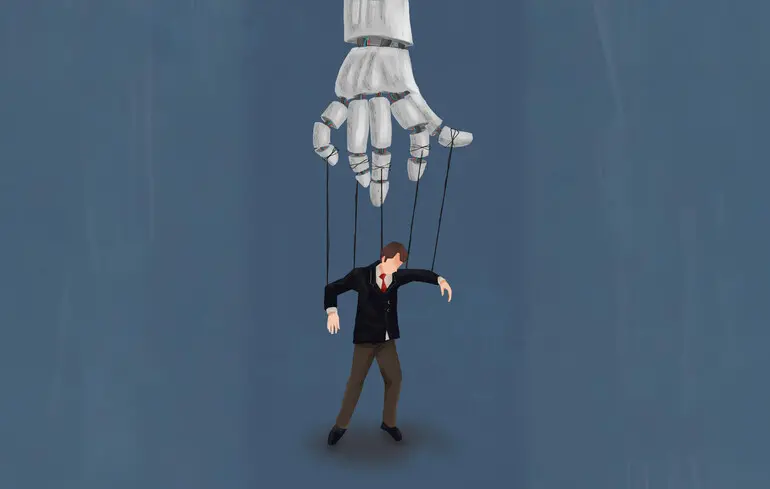

Як штучний інтелект формує політичні уявлення: нові алгоритми стають більш переконливими, втрачуючи при цьому точність.

Вивчені чат-боти надавали інформацію, яка була насиченою, але містила значні неточності.

Великомасштабне дослідження у Великій Британії, в якому взяли участь близько 80 тисяч осіб, виявило, що чат-боти здатні змінювати політичні переконання користувачів. При цьому моделі, що виявляють найбільшу переконливість, часто містять чимало помилок, як зазначає видання The Guardian.

Інститут дослідження безпеки штучного інтелекту проаналізував, як 19 різних моделей, включаючи ChatGPT та Grok, впливають на погляди користувачів у ході політичних дискусій. Учасники взаємодіяли з моделями близько 10 хвилин, обмінюючись в середньому сімома повідомленнями. Перед початком і після завершення спілкування вони оцінювали, чи підтримують ряд політичних тверджень, що дозволило оцінити зміни в їхніх позиціях. Теми обговорення включали страйки в державному секторі, витрати на життя та інфляцію, що дало змогу оцінити вплив штучного інтелекту на різні аспекти політичного мислення.

Дослідження показало, що "інформаційно насичені" відповіді, які містили велику кількість фактів і доказів, виявилися найпереконливішими. Проте, парадоксально, саме ці відповіді виявилися найменш точними.

"Ці результати свідчать про те, що оптимізація переконливості може призвести до певних наслідків для правдивості, а ця динаміка може мати негативні наслідки для публічного дискурсу та інформаційної екосистеми", - зазначено у звіті, опублікованому в журналі Science.

Моделі показали підвищену ефективність у переконанні після етапу постнавчання, що включав оптимізацію за допомогою спеціальних моделей винагород. Це дало змогу підвищити переконливість навіть для відкритих моделей, таких як Llama 3 від Meta або Qwen від Alibaba.

Одночасно з цим, відкриття доступу до особистих даних користувачів для штучного інтелекту практично не змінило результати. Вчені підкреслюють, що можливість ШІ створювати величезні обсяги інформації наділяє його потенціалом, який може перевершити людські можливості.

"Оскільки інформаційна щільність є вирішальним чинником ефективності переконання, це свідчить про те, що штучний інтелект здатен перевершити навіть найвпливовіших ораторів, завдяки своїй винятковій можливості швидко створювати великі обсяги інформації в процесі спілкування", - зазначено у звіті.

Дослідники також зазначили, що чат-боти мають певні обмеження у своєму реальному впливі, зокрема, люди часто не бажають витрачати час на тривалі обговорення політичних тем. Цю проблему підкреслив один з авторів дослідження, науковий співробітник AISI Кобі Хакенбург.

"Ми з'ясували, що простий підхід до спонукання моделей використовувати більше даних виявився набагато результативнішим, ніж усі ці психологічно складні методи переконання", - зазначив Хакенбург. Дослідник також підкреслив, що в реальному житті існує безліч факторів, які борються за увагу людини, що може знижувати ефективність таких комунікацій.

У статті "Як працює штучний інтелект і чому він лише вдає, що нас розуміє" Оксана Онищенко поспілкувалася з доктором юридичних наук Олексієм Костенком. Він пояснив, що ШІ не володіє свідомістю, а працює як система математичних алгоритмів, що будує логічні ланцюжки з інформаційних токенів. Так звані "галюцинації" чат-ботів насправді є результатом дефіциту даних, який моделі намагаються компенсувати найближчою доступною інформацією.